Dieser Beitrag handelt über die drei Iterationen einer akusmatischen Studie von Christoph Zimmer, welche im Rahmen des Seminars „Symbolische Klangverarbeitung und Analyse/Synthese“ bei Prof. Dr. Marlon Schumacher an der HFM Karlsruhe durchgeführt wurden. Es wird über die grundlegende Konzeption, Ideen, aufbauende Iterationen sowie die technische Umsetzung mit OpenMusic behandelt.

Verantwortliche: Christoph Zimmer, Master Student Musikinformatik der HFM Karlsruhe

Grundlegende Idee und Konzept:

Ich arbeite normalerweise viel mit Hardware für Musik, besonders gerne auch im Bereich von DIY. Das trifft sich auch oft mit der damit verbundenen Organisation und Optimierung des Workflows die mit dieser Hardware verbunden ist. Als es uns Stundenten zur Aufgabe wurde eine akusmatische Studie in Form von Musique concrète zu produzieren war ich zu beginn orientierungslos. Bisher habe ich mich nur wenig mit „experimentellen“ Musikgenre beschäftig. Die Existenz von Musique concrète war mir bis zu diesem Punkt ehrlich gesagt nicht einmal bekannt. Ich wurde mit dieser Aufgabe also aus meinem üblichen Workflow, der Klangsynthese mit Hardware, und somit auch meiner Komfortzone herausgeworfen. Jetzt mussten Feldaufnahmen als Samples her.

Meine DIY einstellung hat mich intuitiv zu dem Entschluss gebracht die Samples selber aufzunehmen. Es sollte fokus auf eine Variation an Samples gelegt werden. Von dem Gedanken, mich von meiner bisherigen Arbeit komplett abzukapseln war ich jedoch aber immernoch abgetan. Ich wollte eine „Meta-Verbindung“ zu meinem Hardware fokusierten arbeiten in das Stück einbringen. Basierend auf dieser Idee entstand dann das Stück „chris baut einen rollwagen für seine hardware“

Der fertige Rollwagen für Hardware. Weitere Bilder unter: https://www.reddit.com/r/synthesizers/comments/ryyw8e/i_finally_made_a_proper_stand_for_my_synth_rack/

Erste Iteration

Das Stück sollte also aus Samples bestehen welche nicht willkürlich produziert oder aus dem Internet heruntergelden wurden, sondern als „Nebenprodukt“ einer tatsächlich selbst durchgeführten Arbeit entstehen, in diesem Fall das Konstruieren eines Rollwagens für Musik-Hardware. Im Laufe von zwei Wochen habe ich mit meinem Smartphone die bei dem Durchlaufen verschiedenster Arbeitsschritte entstehende Klänge aufgenommen. Da ich mir in diesen Arbeitsschritten unterschiedliche Materialien und Bearbeitungsmethoden zu nutze machte, entstand nicht nur eine große Variation an Klangtexturen, sondern es bildete sich auch von selbst die makroskopische Struktur des Stückes. Es hat sich damit sozusagen von selbst komponiert. Die gewünschte Meta-Verbindung ist somit entstanden. Als der Rollwagen nun komplett war, wurde es Zeit mit der Produktion des Stückes zu beginnen.

Die Rohaudio-Dateien der Aufnahmen sind jeweils mehrere Minuten lang. Um die Handhabung in OpenMusic zu vereinfachen, wurden die einzelnen Klangelemente als .wav Dateien exportiert. Dafür wurde die DAW REAPER genutzt. Das Resultat waren etwa 350 einzenlne Samples. Unter folgendem Link sind diese verfügbar:

https://drive.google.com/file/d/1hRk4OZvNEJLkpo_bzSZxP1lwO0YlcpLy/view

Hier ein paar Beispiele der verwendeten Klangelemente:

Mit den vorbereiteten Samples konnte nun das Arbeiten in OpenMusic beginnen.

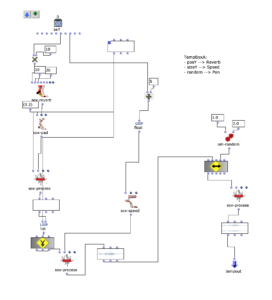

Wie es für Musique concrète üblich ist, sollten die Samples mit verschiedenen Effekten bearbeitet werden um den musikalischen Kontext zu stützen. Für mich war es aber auch wichtig, dass diese nicht so dominieren, dass die Klänge unerkennbar werden und der Kontext verloren geht. Deswegen kam mir die Idee, für das Arrangement ein Workspace innerhalb eines OpenMusic Patches zu programmieren, um die Samples dynamisch bearbeitbar zu machen. Dafür stellte sich das „Maquette“ Objekt als optimal heraus. Grundlegend ermöglicht diese es andere Objekte innerhalb in einer x-Achse (Zeit) und y-Achse (parametrisierbar) zu platzieren. Diese Objekte können dann auf ihre eigene Eigenschaften im Kontext zu der Maquette zugreifen. Diese Funktionen habe ich dann zu nutzte gemacht um vier verschiedene „Template Temporal Boxes“ zu erstellen welche in verschiedener Weise die parametrisierung der Maquette nutzen um Effekte auf die jeweiligen Samples anzuwenden. Das nutzen von mehreren Vorlagen reduziert weiterhin die Komplexität, während eine Variation an Modulationsmöglichkeiten erhalten bleibt:

tempboxa

- Position y –> Reverbance

- Size y –> Playback speed

- Random –> panning

OM Patch der tempboxa

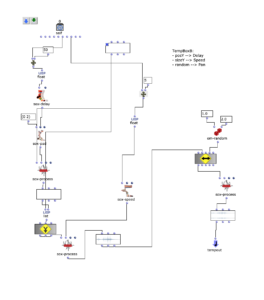

tempboxb

- Position y –> Delay time

- Size y –> Playback speed

- Random –> panning

OM Patch der tempboxb

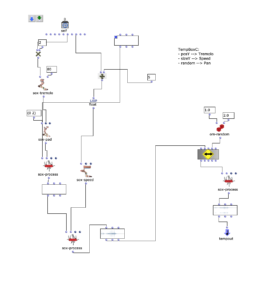

tempboxc

- Position y –> Tremolo speed

- Size y –> Playback speed

- Random –> panning

OM Patch der tempboxc

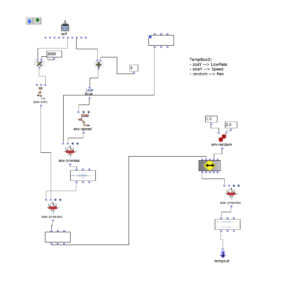

tempboxd

- Position y –> Lowpass cutoff frequency

- Size y –> Playback speed

- Random –> panning

OM Patch der tempboxd

Mit dem Erstellen dieser Boxen konnte die Komposition des Stückes beginnen.

Wie schon erwähnt wurde, sollte die makroskopische Struktur des Ablaufs der Konstruktion beibehalten werden. Praktisch wurden bestimmte Samples der Sektionen (Recherche, Skizzieren, Stahl verarbeitung, Schweißen, Stahl bohren, 3d Druck, Holz Bohrung, Holz schleifen, Streichen und Montage) ausgewählt um diese mit den parametrisierten Tempboxes zu interessant klingenden Kombinationen zu verarbeiten, welche den aktuellen Arbeitsschritt beschreiben sollen.

Ausschnitt der Maquette mit Arrangement

Das Resultat der ersten Iteration:

Zweite Iteration

Mein Ziel der zweiten Iteration war es Akzentierungen auf Samples, welche Ankerpunkte des Stückes darstellen, zu setzen. Genauer gesagt, sollte das in der ersten Iteration verwendete Panning überarbeitet werden, indem die vorhandene Logik mit einem provisorischen Haas Effekt (Delay zwischen dem linken und rechten Kanal) ausgestattet wird. Hierfür wird das Resultat des bisherigen Pannings invers dupliziert und dann mit einem Delay (bis 8 ms) und Level adjustment erweitert, welche sich dynamisch zu der stärke des Pannings verhalten. Schließlich werden beide Sounds gemerged und aus der tempbox ausgegeben.

OM Patch des erweiterten Pannings

Das Resultat der ersten Iteration:

Dritte Iteration

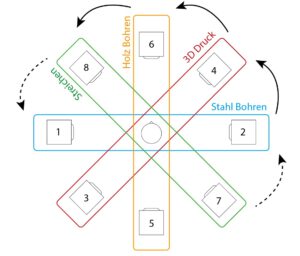

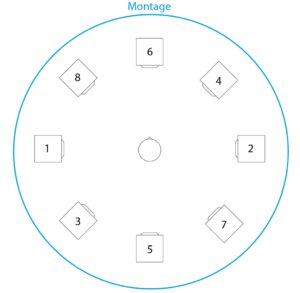

Für die dritte und letzte Iteration wurde es zur Aufgabe, das Stück für ein beliebig wählbares Setup von 8 Kanälen zur Verfügung zu stellen. Die Struktur sollte dabei nicht verändert werden. Dies gab mir wieder die Möglichkeit an dem Panning zu arbeiten. Anstatt die Grenze des Panning Randomizers auf 8 Kanäle zu setzten, kam mir der Gedanke die makroskopische Struktur noch weiter vorzuheben. Dafür habe Ich das folgende Setup von Lautsprechern gewählt:

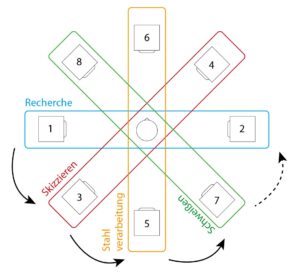

Setup der Lautsprecher (mit Nummerierung der Kanäle)

Mit diesem Setup ist es möglich abhängig von den Sektionen des Stückes das Panning auf jeweils zwei gegenüberliegende Lautsprecher zu verteilen. Im Ablauf des Stückes soll sich der Klang dann als langsame Rotationsbewegung um den Zuhörer bewegen.

Teil 1 des makroskopischen Pannings

Teil 2 des makroskopischen Pannings

Teil 3 des makroskopischen Pannings

Dieses Prinzip trifft parallel auf die Akzentierung mancher Samples von der zweiten Iteration: Während sich die anderen Samples (je nach Sektrion) auf verschiedene Lautsprecher-Paare verteilen, bleiben die Anker-Elemente auf den Kanälen 1 und 2 bestehen.

Die finale Version ist auch im 2 Kanal Format verfügbar:

Vierte Iteration

Bei dieser Iteration wurde es zur Aufgabe mit den Tools welche wir im Rahmen der Veranstaltung „Visuelle Programmierung der Raum/Klangsynthese“ (VPRS) bei Prof. Dr. Marlon Schumacher und Brandon L. Snyder erlernt haben das Stück zu Spatialisieren

„chris baut einen Rollwagen für seine hardware“ war an diesem Punkt schon so weit ausgebaut, dass ich dieses bei Metamorphoses 2022 (ein Wettbewerb für akusmatische Stücke) eingereicht habe. Hierfür war es notwendig, das Stück auf ein 16 Kanal Setup zu mixen. Aufgrund der baldigen Deadline blieb mir nur wenig Zeit um das Stück auf die Anforderungen anzupassen. Deswegen wurden die Kanäle einfach in REAPER verdoppelt und ein LFO Panning auf die jeweiligen Paare hinzugefügt. Leider wurde das Stück im Nachhinein nicht akzeptiert, da die Länge des Stückes nicht den Anforderungen entsprachen. Da auch die Spatialisierung zu wünschen übrig lies, kam mir die Gelegenheit also gerade recht die neu gelernten Tools zu nutzen um diese zu verbessern.

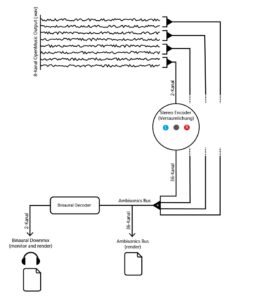

Ich entschloss mich die Metamorphoses 16-Kanal Spatialisierung zu verwerfen und den Stand der dritten Iteration wieder aufzugreifen. Mein Ziel war eine Spatialisierung, welche nicht nur auf die makroskopische Struktur (wie z.B. die Abschnitte Stahl Verarbeitung, 3D Druck…) eingeht, sondern auch in die mikroskopische Struktur, also einzelne Klänge dynamischer auszulegen. Als Ausgangsmaterial diente das aus OM exportierte Audio (8 Kanal), welches dann mithilfe der Ambisonics (IEM) VSTs bearbeitet werden sollte.

Die Ambisonics Template für REAPER wurde als Workspace Vorlage verwendet ,da diese schon ein Setup für die Audio Busse bereitstellte um schließlich ein Ambisonics File 5. Ordnung und ein Binauralen Stereo Downmix zu rendern. Im ersten Schritt wurden die 8 Kanal Audio Datei so geroutet, dass sich diese separiert bearbeiten ließen. Hierfür wurden jeweils Kanal 1-2 , 3-4, 5-6 und 7-8 zu neuen Tracks geschickt und der Master-Send deaktiviert. Diese Tracks wurden dann als Multikanal Tracks mit 36 Kanälen definiert und der Stereo Encoder (IEM) in die Effekt Chain eingefügt. Die Parameter für die Spatialisierung (Azimuth, Elevation, Roll und Width) wurden dann als Envelopes in die Timeline von REAPER hinzugefügt um deren dynamisch Bearbeitung zu ermöglichen. Schließlich können alle Tracks in den Ambisonics Bus zusammengeführt werden. Der Binaurale Downmix wurde dabei als Monitoring Ausgang verwendet.

Eine vereinfachte Darstellung des Routings in REAPER

Praktisch wurden Punkte per Hand in die Envelope Tracks eingefügt, zwischen welchen dann linear Interpoliert wurde um dynamische Veränderungen der Parameter hervorzurufen. Hierbei bin ich intuitiv Vorgegangen und habe mir Abschnitte vereinzelt angehört um mir eine grundlegende Vorstellung zu bilden, welche Art von Spatialisierung diesen Abschnitt unterstreichen würde. Dann wurde auf die einzelnen Klänge und ihre Herkunft eingegangen, und versucht mit Hilfe der Parameter diese zu Beschreiben. Beispiele dafür sind: beim Bohren eine schneller werdende Drehbewegung, bei dem Piepsen der digitalen Eingabe des 3D-Druckers ein hin und her Springen oder beim Zusammenknüllen von Papier ein komplettes Durcheinander. Mir war diese Form von Workflow bereits gängig, nicht nur durch das Verwenden von DSP VSTs in der DAW, sondern auch bei dem Programmieren von DMX Lichtern über den Envelope.

Bei der Bearbeitung Empfand ich das visuelle Feedback des EnergyVisualizer (IEM) nicht nur sehr hilfreich um den Überblick zu behalten. Ich entschloss mich deswegen diese Aufzunehmen und zu dem Binauralen Downmix zuzufügen:

Alle unkompremierten Dateien finden sie unter folgendem Link: https://drive.google.com/drive/folders/1bxw-iZEQTNnO92RTCmW_l5qRFjeuVxA9?usp=sharing