Marlon Schumacher wird zusammen mit Esther Fee Feichtner als Co-Chairs für Music and Installation Submission dienen für das IEEE

5th International Sympoisum on the Internet of Sounds.

das vom 30. September bis 2. Oktober 2024 in den International Audio Laboratories Erlangen stattfindet. Folgen Sie diesem Link zur offiziellen IEEE Website:

„Das Internet der Klänge ist ein aufstrebendes Forschungsgebiet an der Schnittstelle zwischen den Bereichen Sound und Music Computing und dem Internet der Dinge. […] Ziel ist es, Akademiker und Industrie zusammenzubringen, um die Entwicklung von Internet-of-Sounds-Technologien mit Hilfe neuartiger Werkzeuge und Prozesse zu untersuchen und voranzutreiben. Die Veranstaltung besteht aus Vorträgen, Keynotes, Panels, Posterpräsentationen, Demonstrationen, Tutorials, Musikaufführungen und Installationen.“

Das Internet of Sounds Research Network wird von einer beeindruckenden Anzahl (> 120) von Institutionen aus über 20 Ländern unterstützt, mit einem eigenen IEEE-Komitee für neue Technologieinitiativen. Zu den Partnern aus Deutschland gehören:

-

-

International Audio Laboratories Erlangen, eine gemeinsame Einrichtung der Friedrich-Alexander-Universität Erlangen-Nürnberg und des Fraunhofer IIS. [Hauptansprechpartner].

-

Technische Universität Dresden, Institut für Kommunikationstechnik.[Hauptansprechpartner].

-

Leibniz Universität Hannover, Institut für Nachrichtentechnik.[Hauptansprechpartner].

-

Sennheiser.[Hauptansprechpartner].

-

Fraunhofer-Institut für Digitale Medientechnologie (IDMT), Gruppe Industrielle Medienanwendungen. [Hauptansprechpartner].

-

Universität der Künste Berlin, Sound Studies und Sonic Arts.[Hauptansprechpartner].

-

Hochschule für Musik und Theater Hamburg, LIGETI Center.[Hauptansprechpartner].

-

Hochschule Anhalt University of Applied Sciences.[Hauptansprechpartner].

-

Ostfalia Hochschule für angewandte Wissenschaften, Forschungsgruppe IoT / IIoT.[Hauptansprechpartner].

-

Hochschule für Technik und Wirtschaft Berlin, Fachbereich Populäre Künste.[Hauptansprechpartner].

-

Soundjack.[Hauptansprechpartner].

-

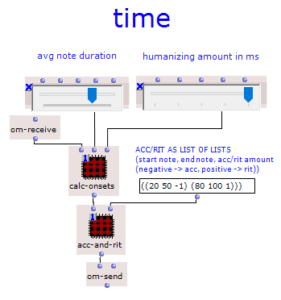

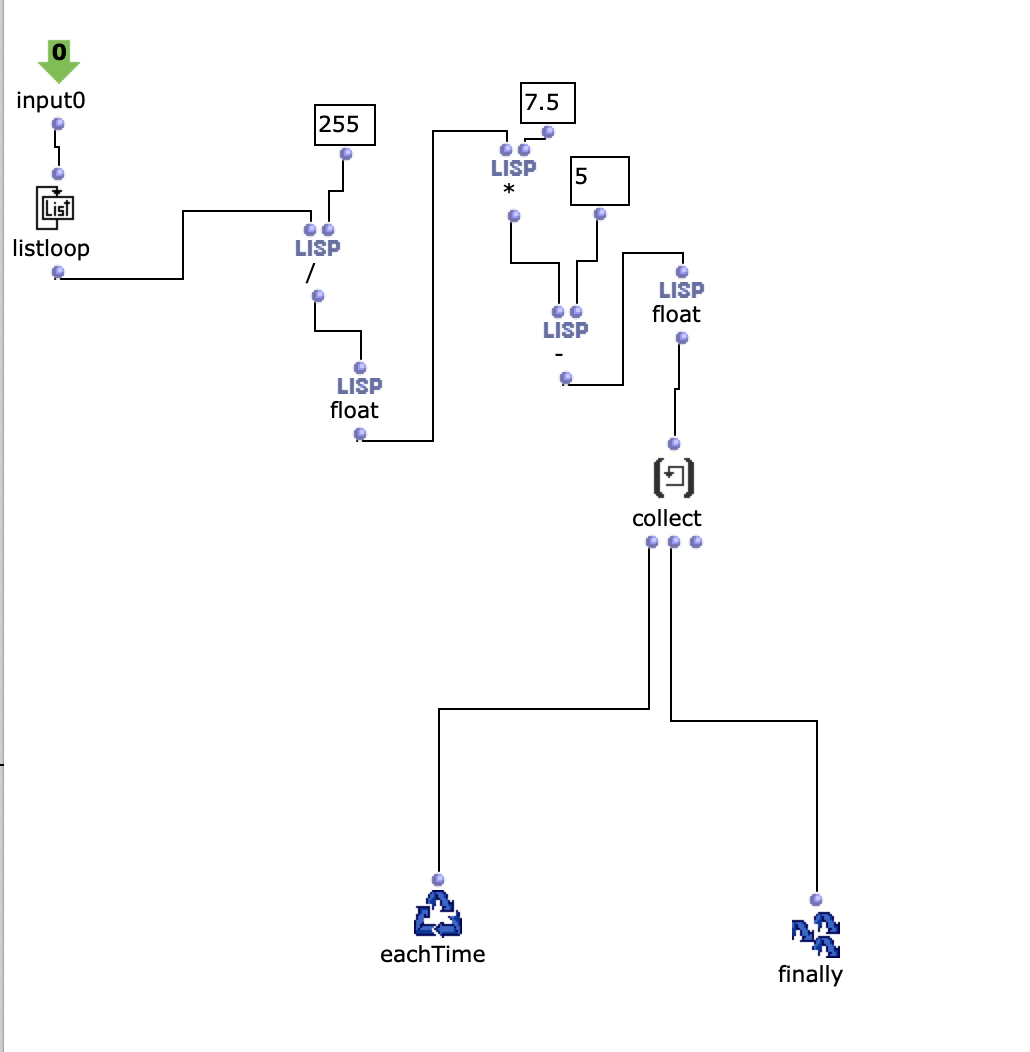

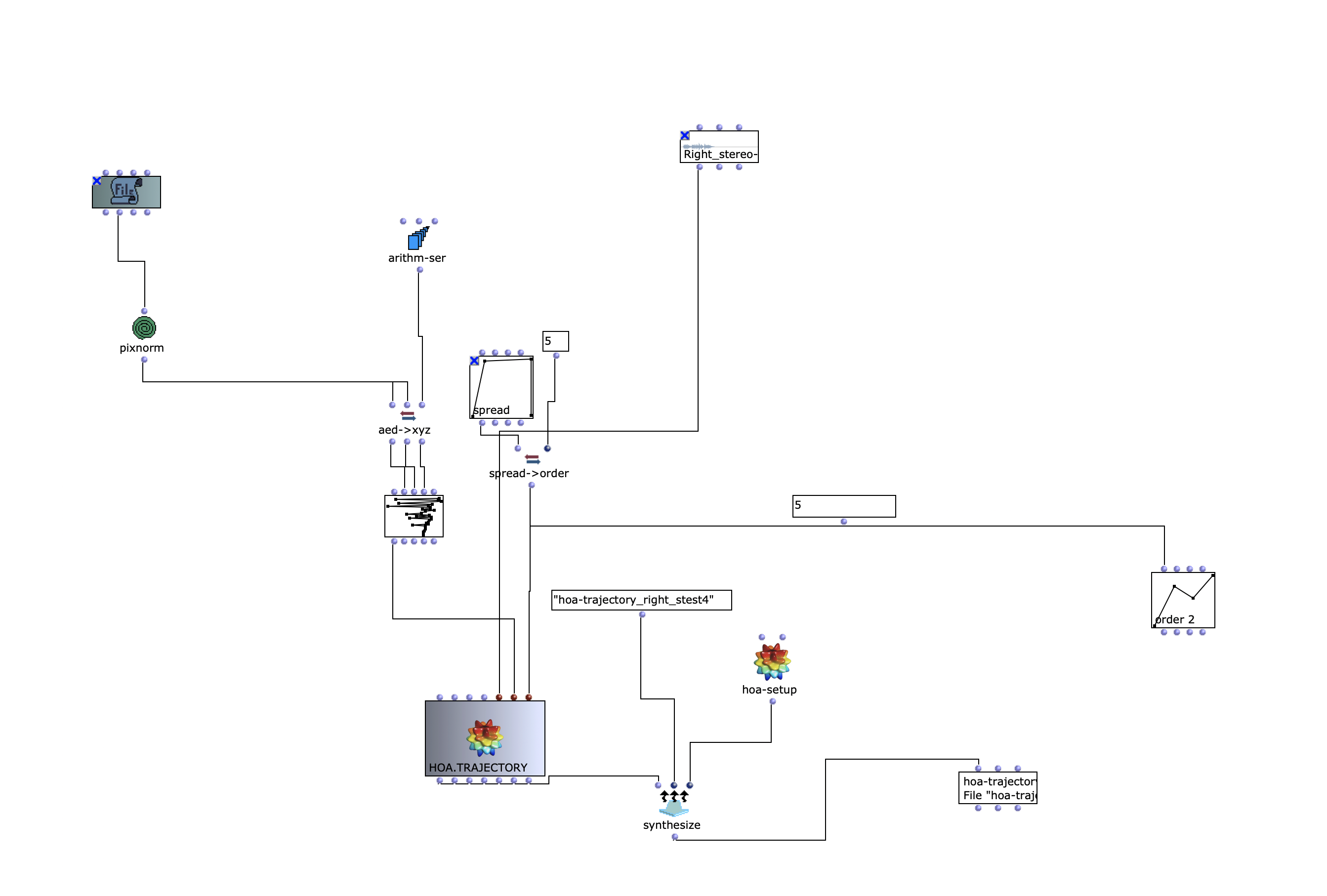

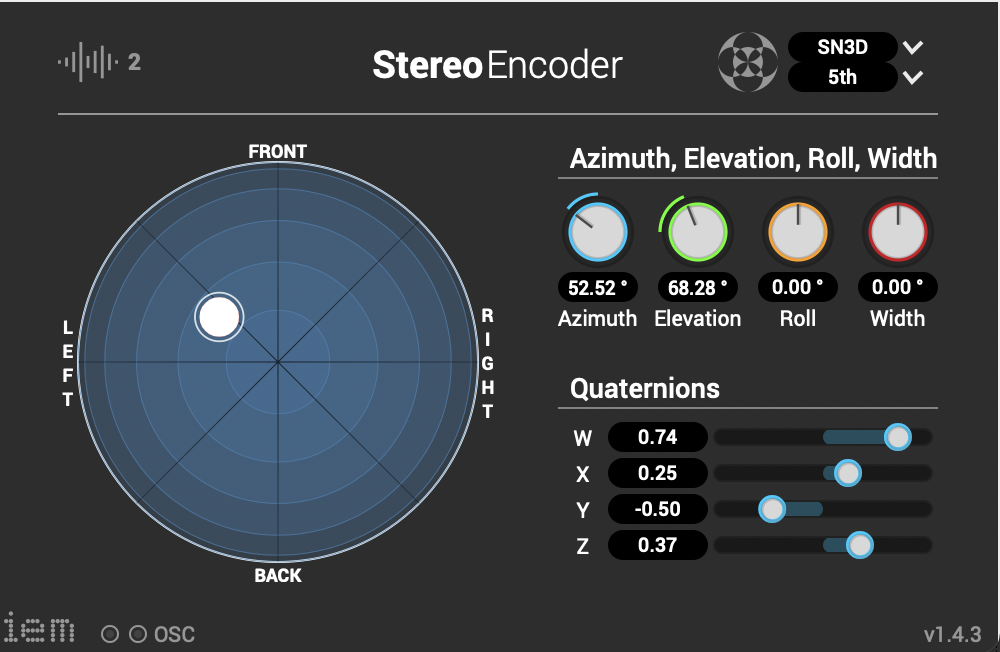

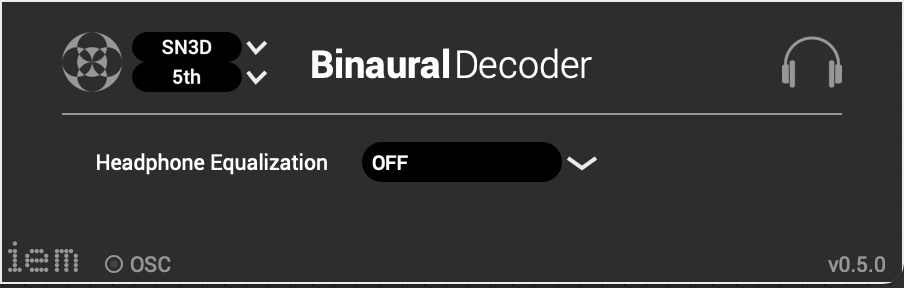

Die Stereo und Monofiles wurden zuerst in 5th Order Ambisonics Codiert (36 Kanäle) und schließlich mit dem binauralen Encoder in zwei Kanäle umgewandelt.

Die Stereo und Monofiles wurden zuerst in 5th Order Ambisonics Codiert (36 Kanäle) und schließlich mit dem binauralen Encoder in zwei Kanäle umgewandelt.

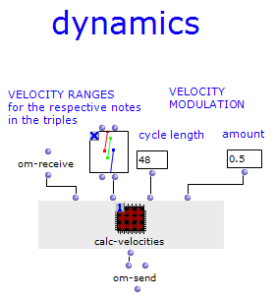

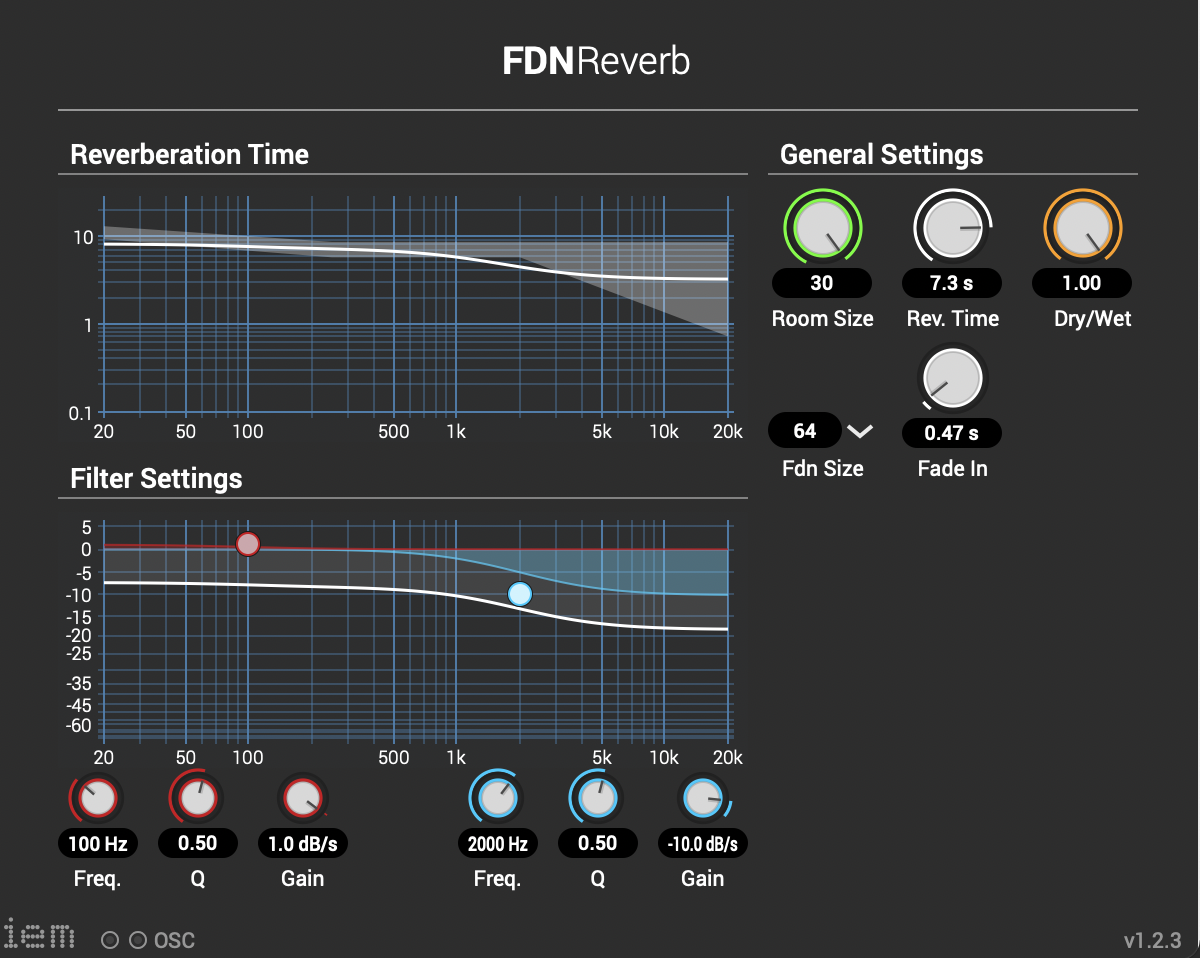

Andere Effekte zur Nachbearbeitung(Detune, Reverb) wurden von mir selbst programmiert und sind auf Github verfügbar. Der Reverb basiert auf einen Paper von James A. Moorer About this Reverberation Business von 1979 und wurde in C++ geschrieben. Der Algorythmus vom Detuner wurde von der HTML Version vom Handbuch „The Theory and Technique of Electronic Music“ von Miller Puckette in C++ geschrieben. Das Ergebnis der letzen Iteration ist hier zu hören.

Andere Effekte zur Nachbearbeitung(Detune, Reverb) wurden von mir selbst programmiert und sind auf Github verfügbar. Der Reverb basiert auf einen Paper von James A. Moorer About this Reverberation Business von 1979 und wurde in C++ geschrieben. Der Algorythmus vom Detuner wurde von der HTML Version vom Handbuch „The Theory and Technique of Electronic Music“ von Miller Puckette in C++ geschrieben. Das Ergebnis der letzen Iteration ist hier zu hören.