In diesem umfassenden Artikel werde ich den Schaffensprozess meiner Komposition beschreiben, um meine Erfahrung im Zuge der Mehrkanal-Bearbeitungen zu präsentieren. Die Komposition habe ich im Rahmen des Seminars „Visuelle Programmierung der Raum/ Klangsynthese (VPRS)“ bei Prof. Dr. Marlon Schumacher an der HFM Karlsruhe produziert.

Betreuer:: Prof. Dr. Marlon Schumacher

Eine Studie von: Mila Grishkova

Somersemester 2022

Hochschule für Musik, Karlsruhe

✅ Das Ziel

Das Ziel meiner Projektarbeit war es, eine komplette Erfahrung mit der Mehrkanal-Bearbeitung zu bekommen.

Ich benutze 3 Klänge um Komposition zu bauen.

Dann realisiere ich das Stück im Format 3D Ambisonics 5. Ordnung (36-Kanal Audiodatei). Ich benutze Mehrkanal-Bearbeitungen mit OM-SoX Spatialisierung/Rendering in Ambisonics mit OMPrisma, hierbei: Dynamische Spatialisierung (hoa.continuous). Die resultierenden Audio Dateien importiere ich in ein entsprechendes Reaper Projekt (Template wird zur Verfügung gestellt (s. Fig 7)). Innerhalb Reaper sind die Ambisonics Audiospuren mit Plugins bearbeitet.

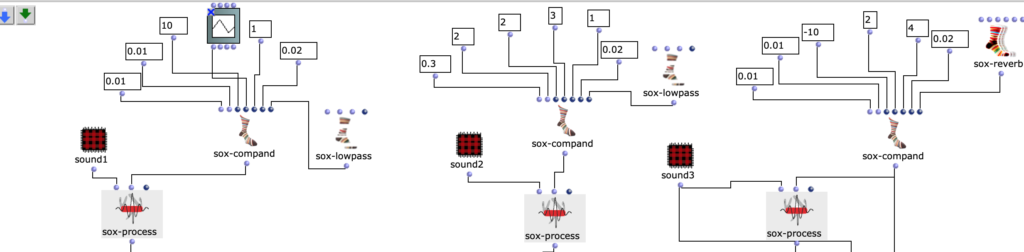

✅ 1. Figur & 1. Sound

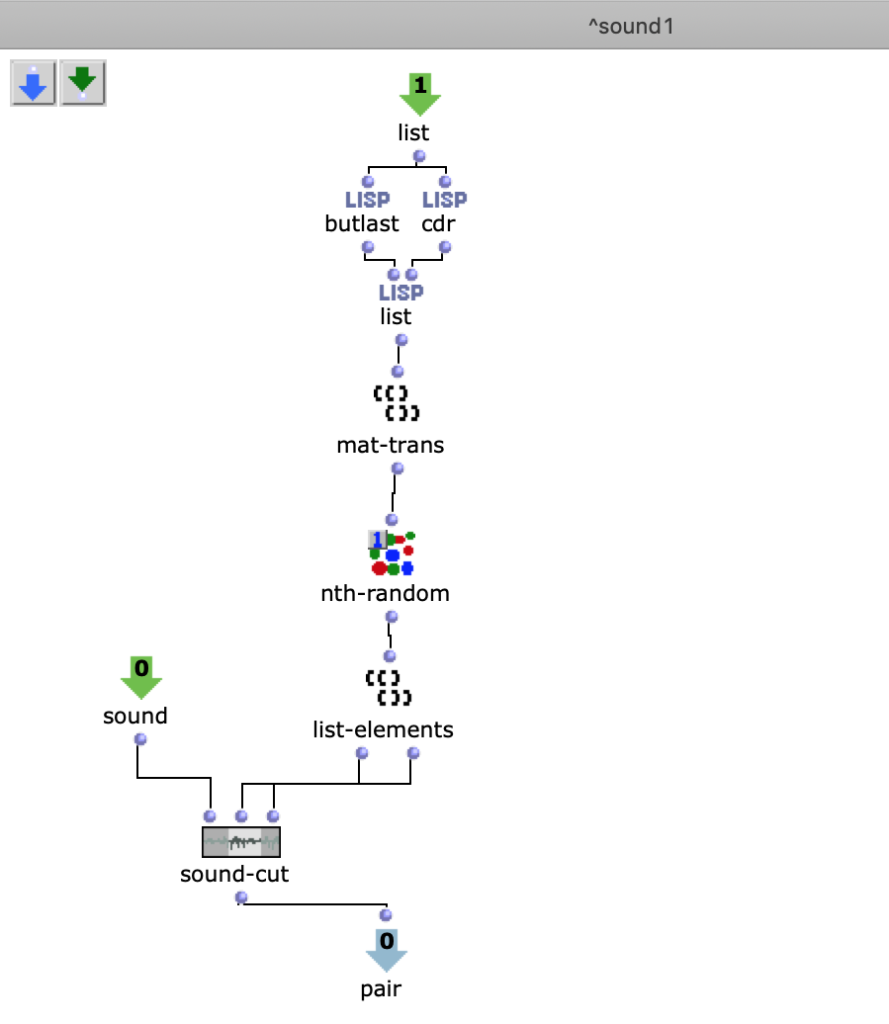

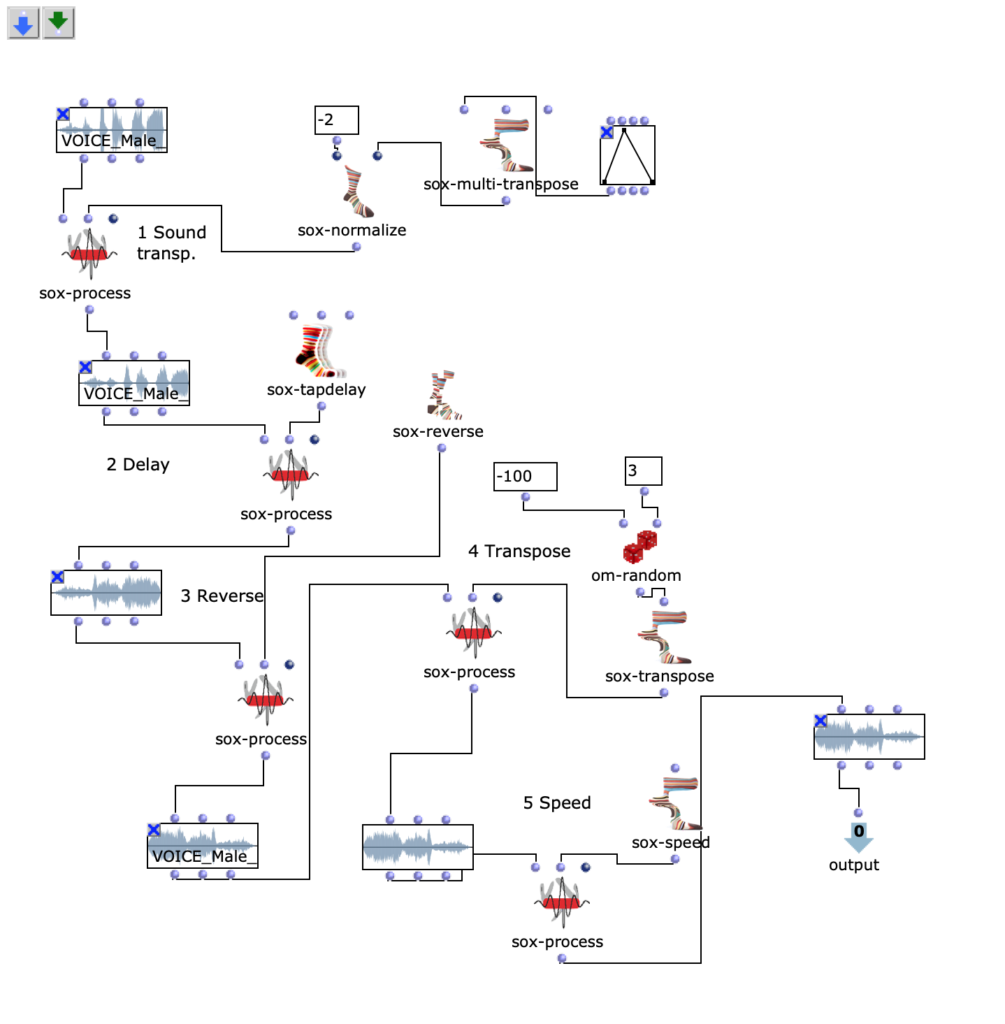

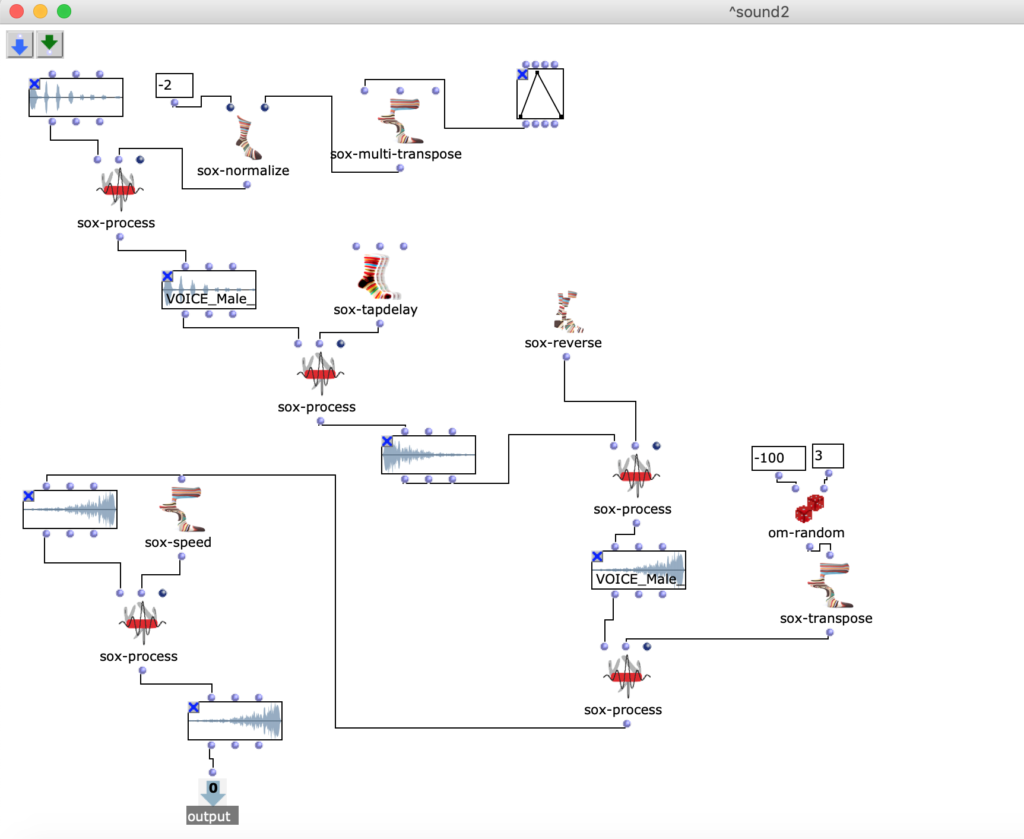

In der 1. Figur kann man einen OpenMusik Patch erkennen. In dem Patch „Sound1“ befindet sich die Methode Sound1 zum bearbeiten. Ich benutze Sound-voice, dann mache ich eine Transposition (OM sox-transpose, OM sox-normalize), dann benutze ich Verzögerungsleitungen (OM sox-tapdelay). Nächster Schritt ist rückwärts (OM sox-reverse). Dann kann man in Patch Transposition sehen und ich benutze die random-Methode (OM sox-random). Das letzte Element dieses Patches ist die Speed-Bearbeitung (OM sox-speed).

Fg. 1 zeigt OpenMusic Patch Sound1: Dieser Patch zeigt transformation des 1.Sounds

Audio I: der erste Klang

✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴

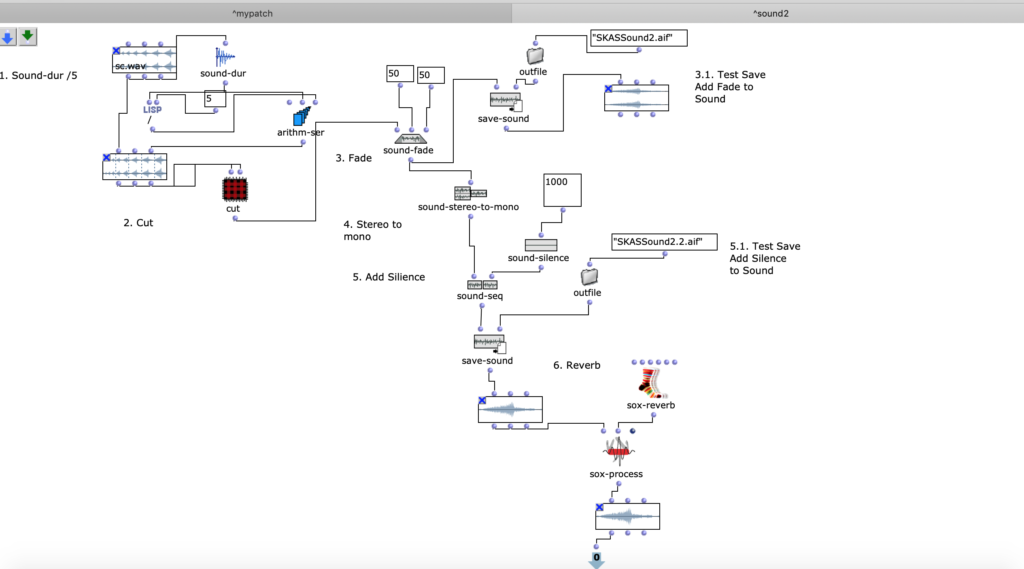

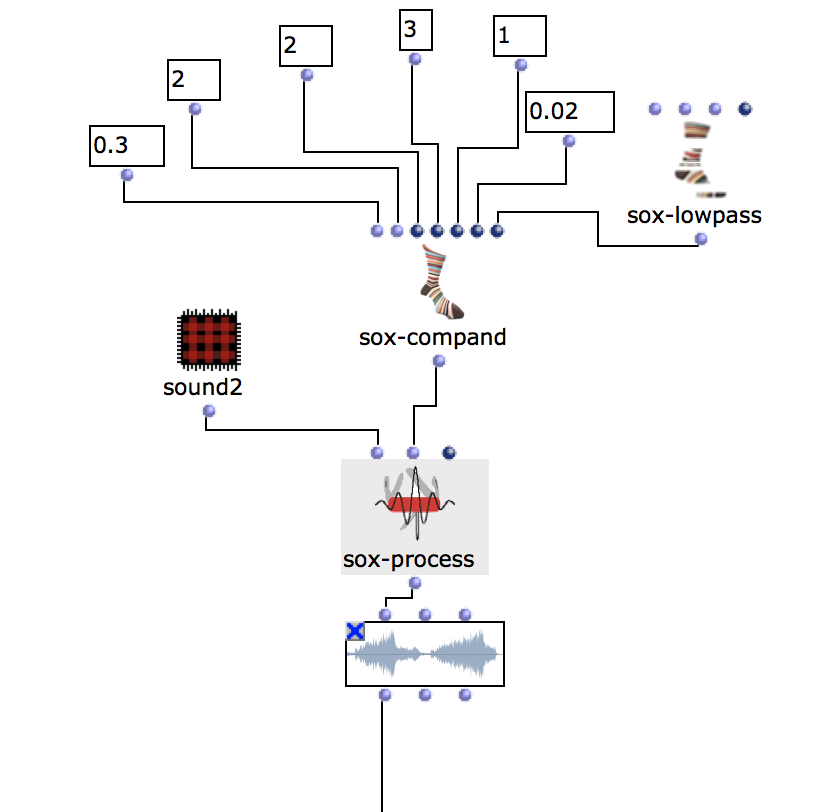

✅ 2. Figur & 2. Sound

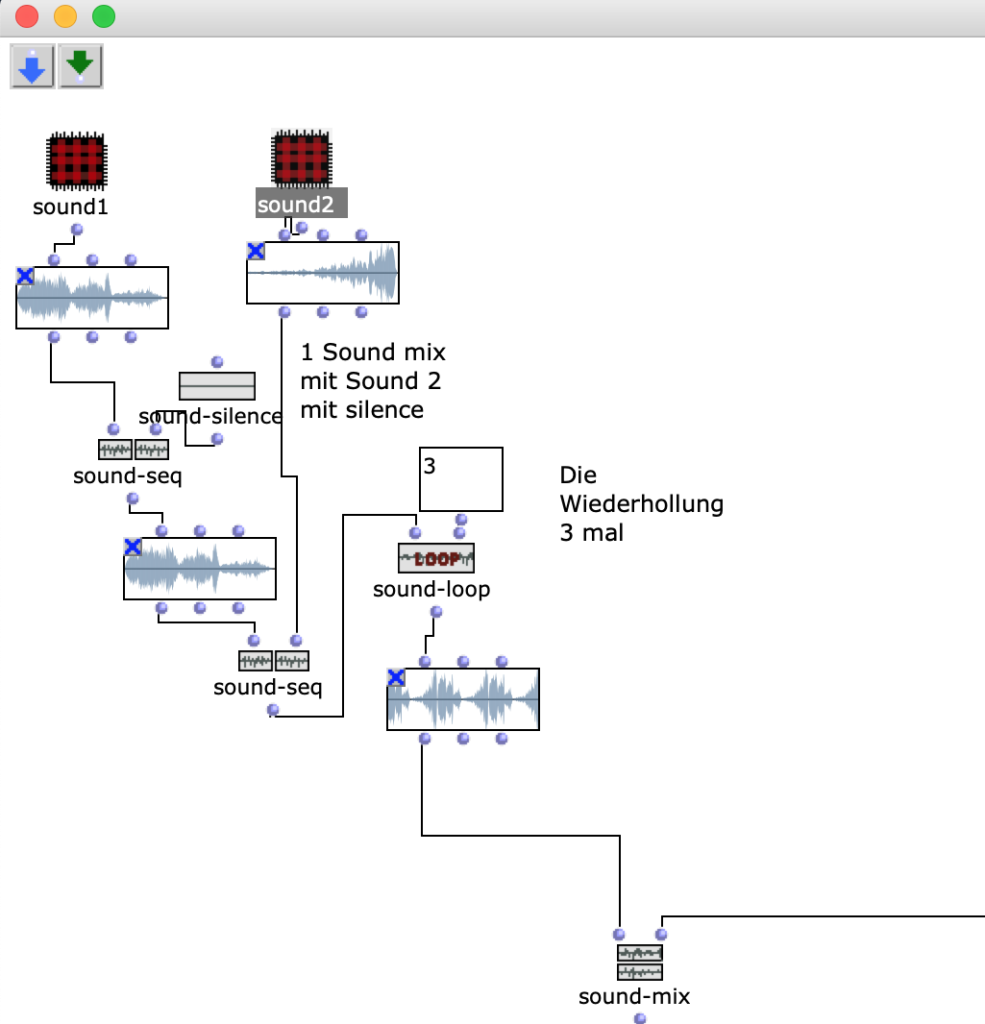

In der 2. Figur kann man einen OpenMusik Patch sehen. In dem Patch „Sound2“ befindet sich die Methode „Sound2“ zum bearbeiten. Ich mache die gleiche Manipulationen, wie mit dem 1. Sound, um 2.Sound zu bearbeiten. Die Beschreibung kann man oben lesen.

Fg. 2 zeigt OpenMusic Patch Sound2: Dieser Patch zeigt transformation des 2.Sounds

Audio II: der zweite Klang

✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴

✅ 3. Figur & 3. Sound

In der 3. Figur kann man den OpenMusic Patch „Mix“ sehen. In diesem Patch befindet sich der MixProzess „2 Klänge“ (OM sound-mix), die ich in den letzten 2 Patches beschrieben habe. Ich addiere Pausen (OM sound-silence) und dann wiederhole ich das Klangmaterial 3 mal (OM sound-loop).

Fg. 3 zeigt OpenMusic Patch „Mix“: Dieser Patch zeigt Sound-mix (Sound 1 und Sound 2).

Audio III: der dritte Klang

✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴

✅ 4. Figur & 4. Sound

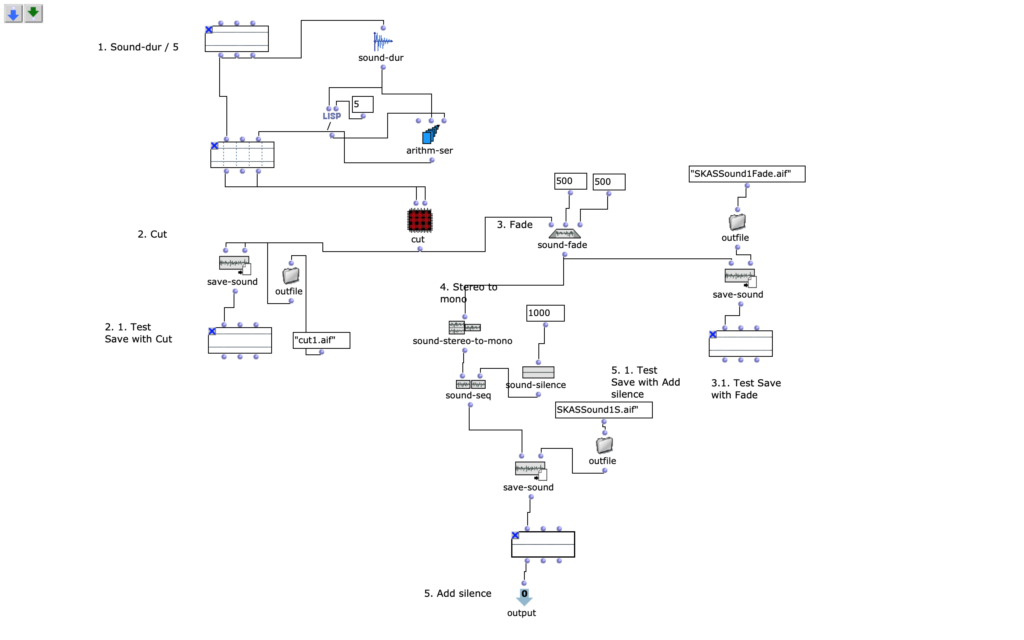

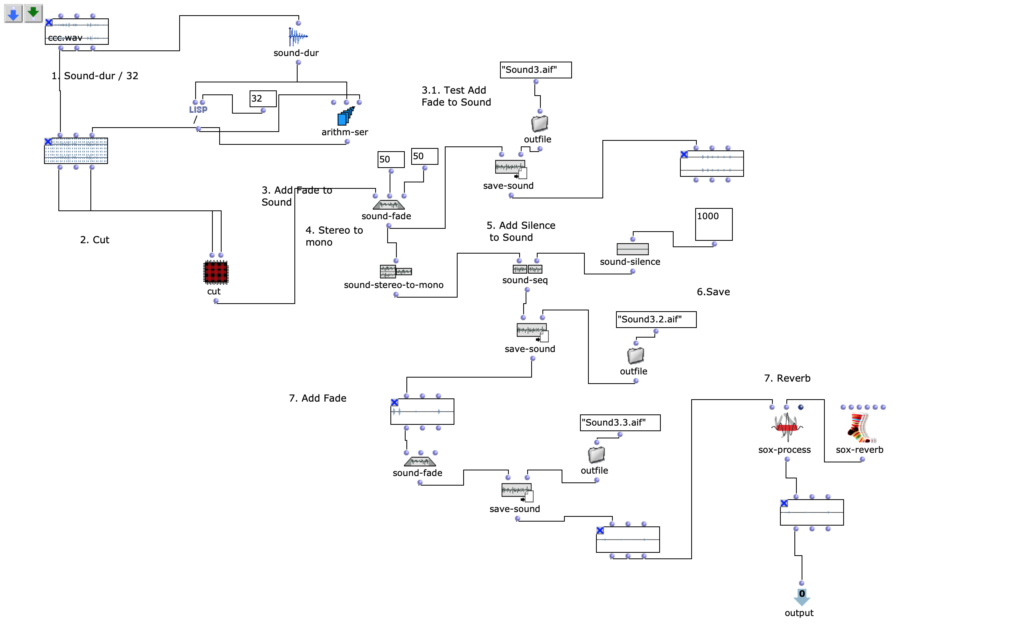

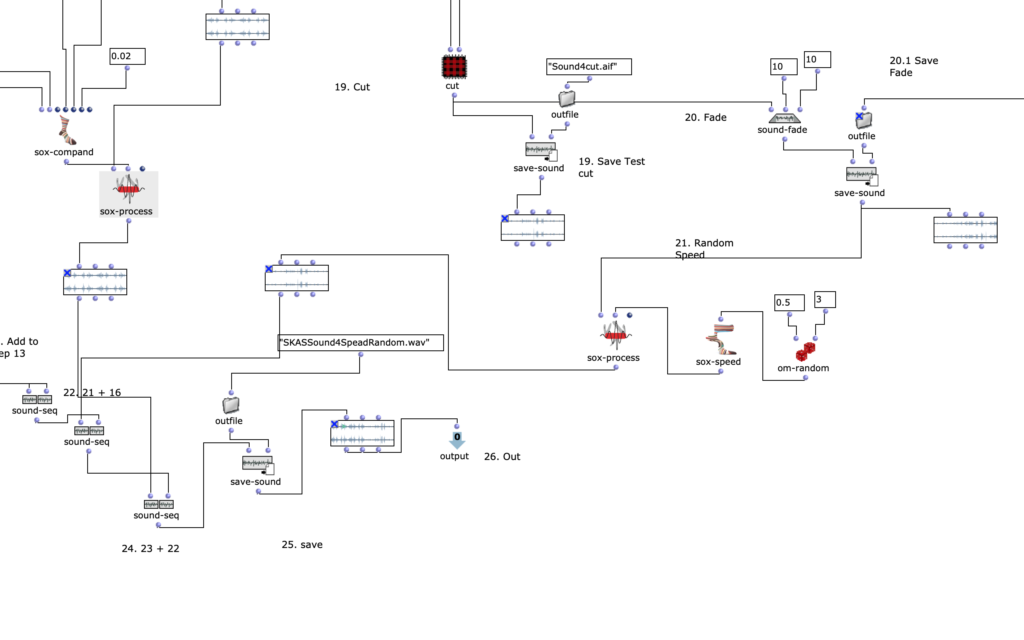

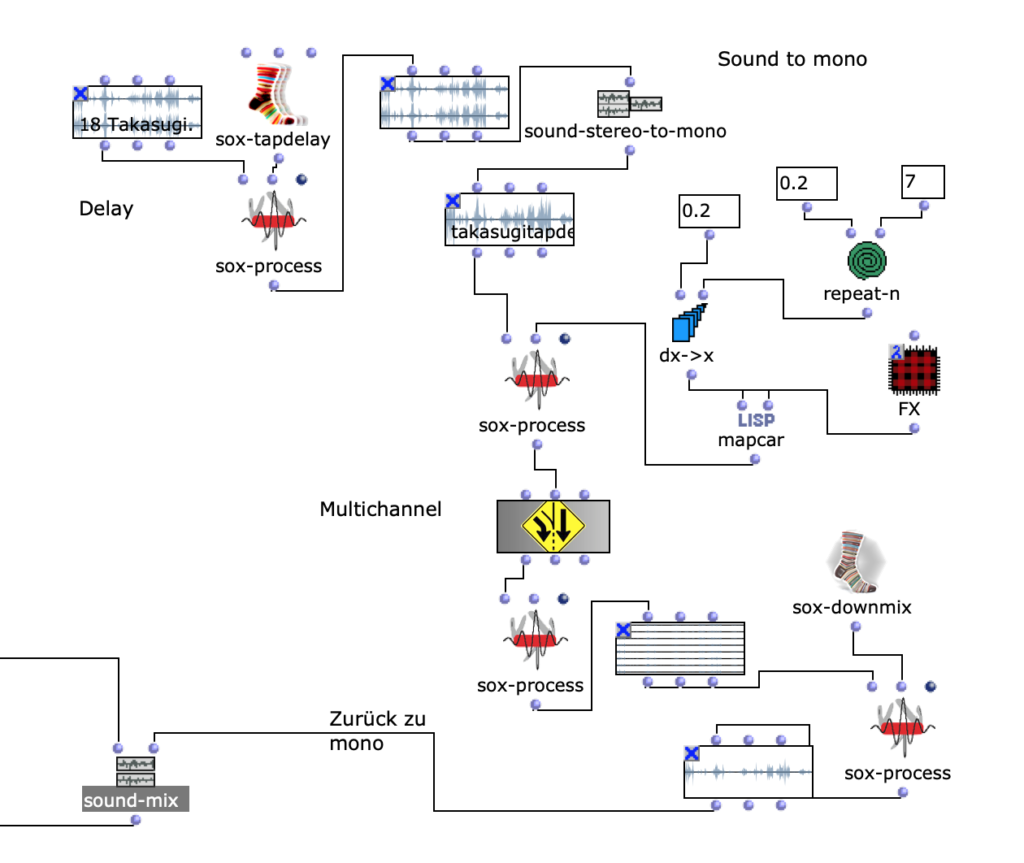

In der 4. Figur befindet sich der Patch 4, in dem man die Bearbeitung der Komposition von Takasugi „Diary of a Lung“ sehen kann.

Der Komponist Steven Kazuo Takasugi hat seine Musikstuck „Diary of a Lung, version for eighteen musicians and electronic playback“ an der Hochschule für Musik Karlsruhe präsentiert und er hat 2 Toningenieure gesucht, die seine Komposition bei dem Konzert live mit mehreren Kanäle abspielen können.

Deswegen, habe ich als Teil meines Materials Takasugi’s Musikstuck genommen.

Fg. 4 zeigt OpenMusic Patch „Takasugi“: Dieser Patch zeigt Bearbeitung des Materials vom Audio Takasugi „Diary of a Lung“

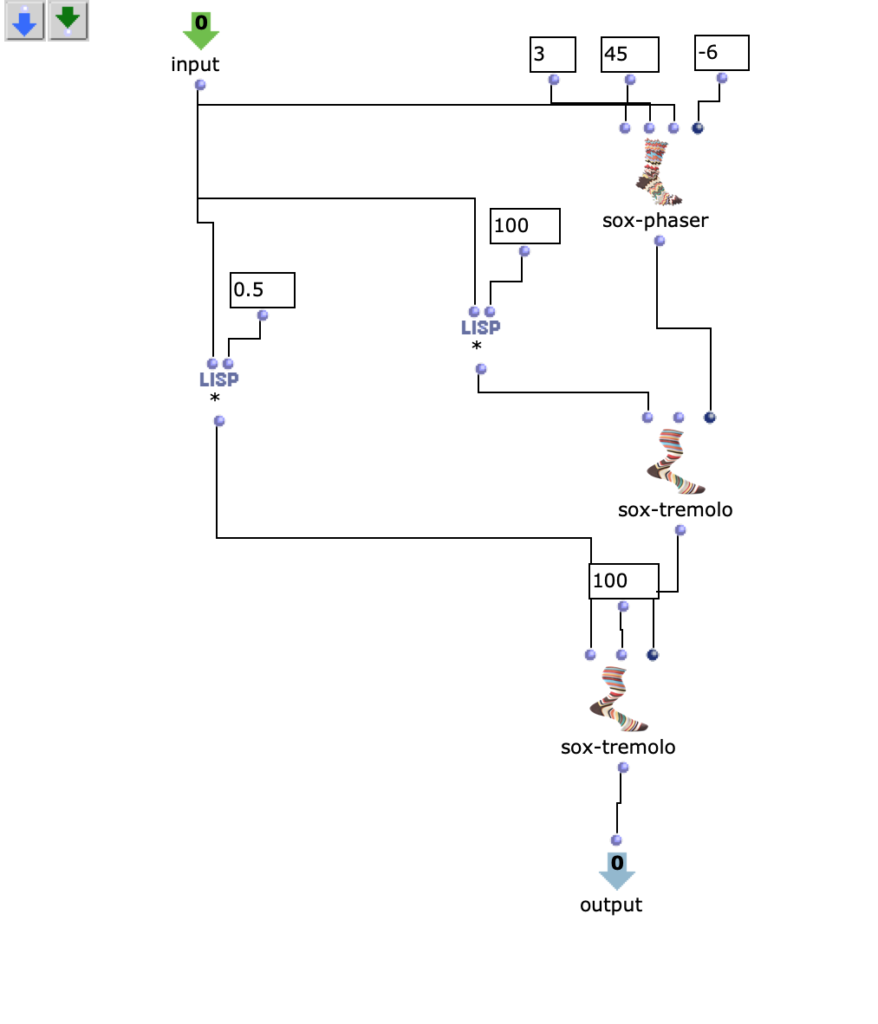

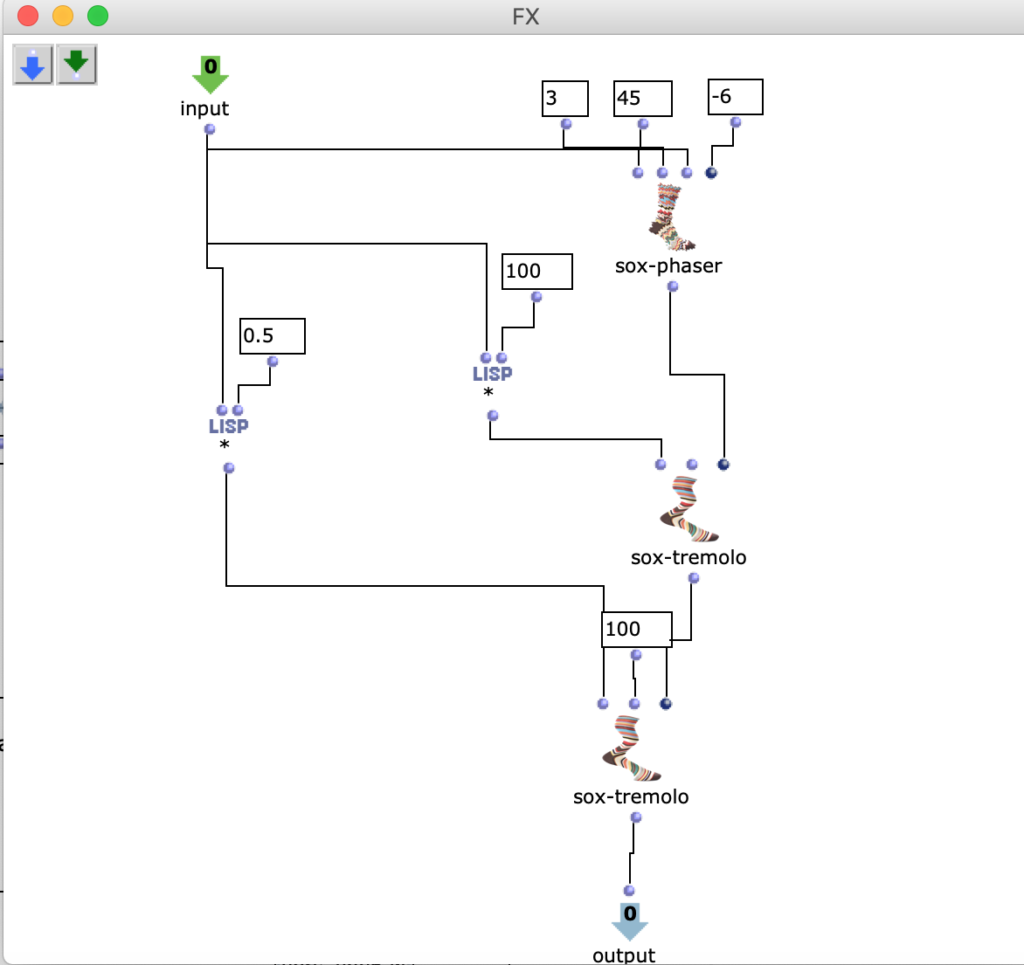

In der nächsten Figur (Fig. 5) kann man den Patch „FX“ sehen.

Fg. 5 zeigt OpenMusic Patch „FX“: Dieser Patch zeigt OM sox-phaser, OM sox-tremolo

Audio IV: der vierte Klang

✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴

✅ 1.Ergebnis

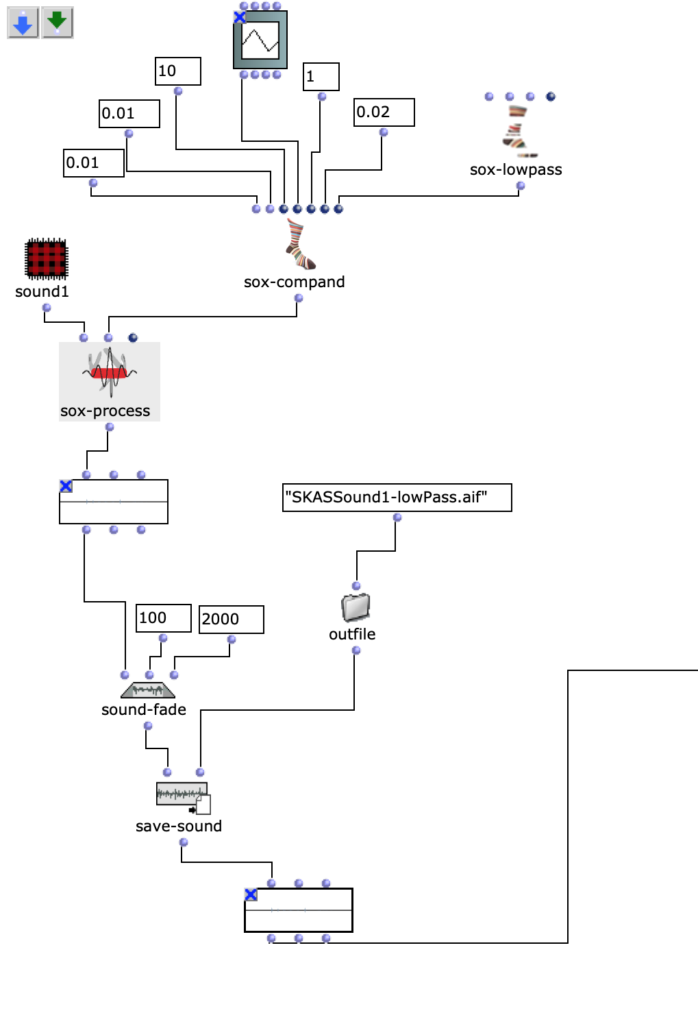

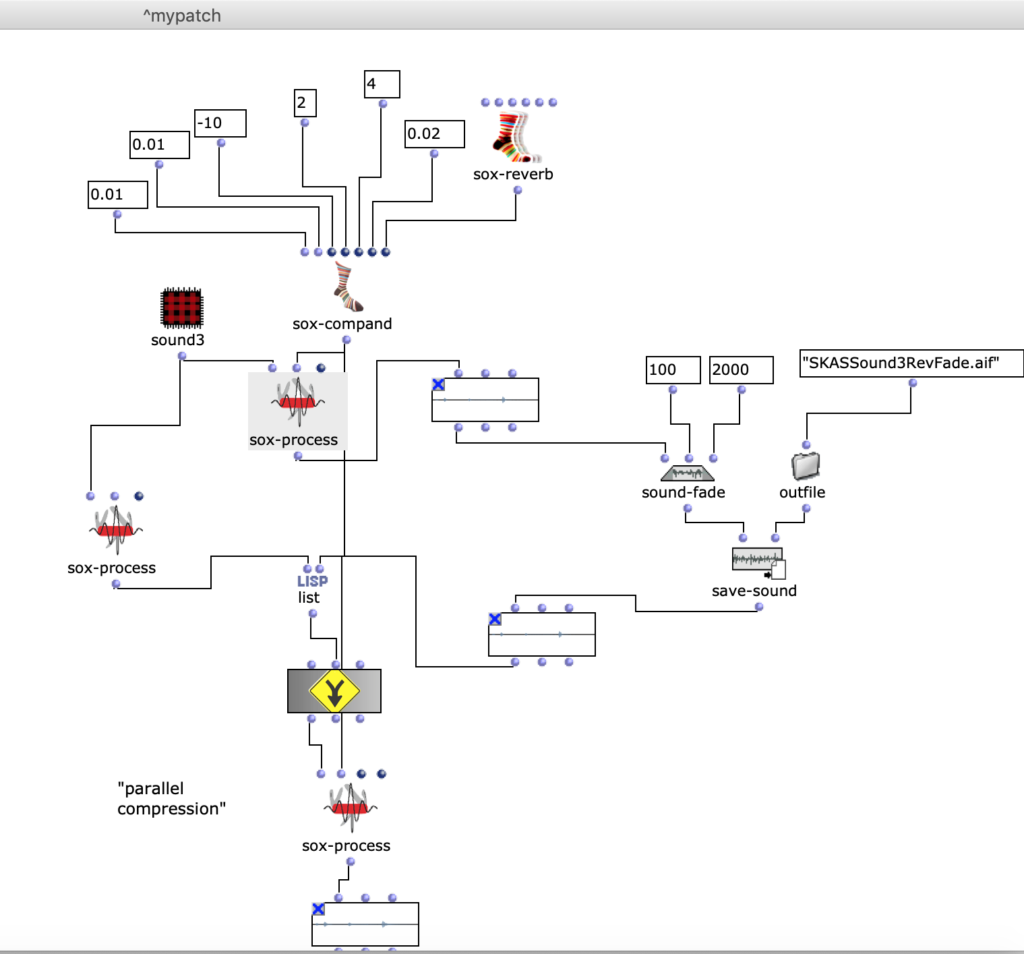

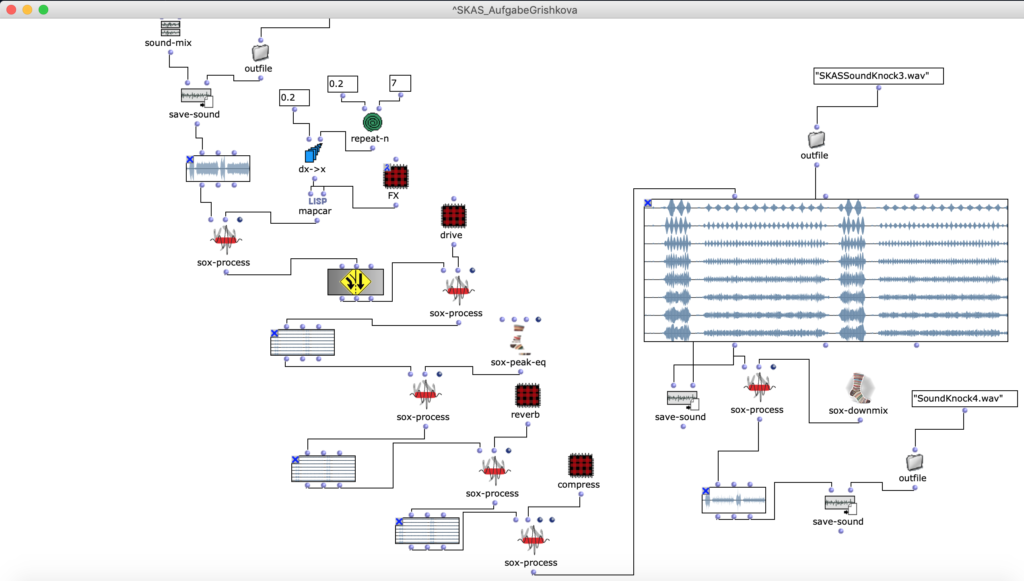

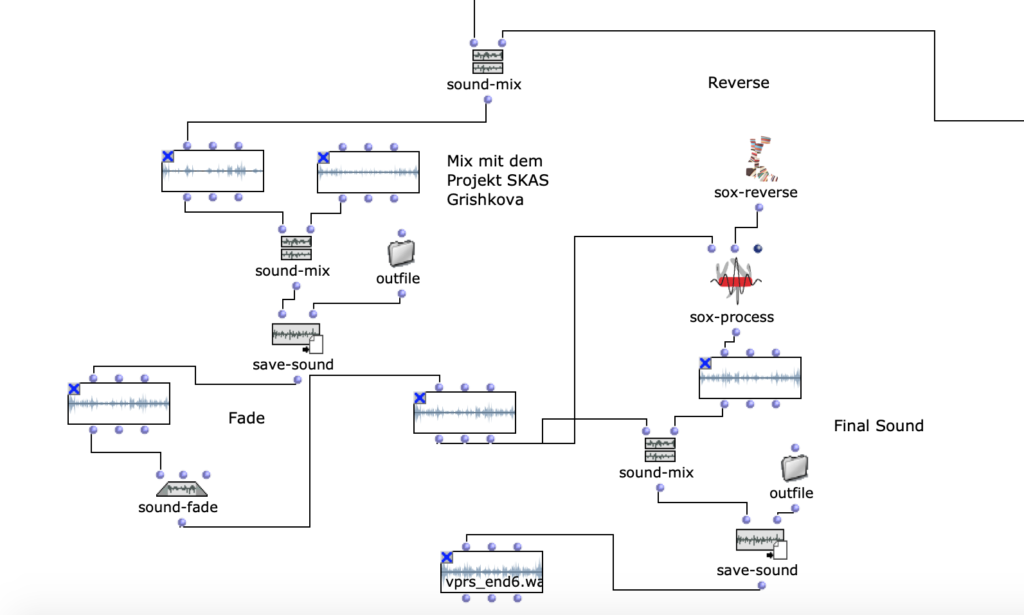

In der 6. Figur sieht man die letzte Bearbeitung. Ich mache einen Mix mit einem Audiomaterial (Mix 2 Sound + Takasugi) und meinem Projekt, welches ich im Rahmen von SKAS realisiert habe. Die Beschreibung des Projekts kann man hier finden.

Fg. 6 zeigt OpenMusic Patch „FinalMix“: Dieser Patch zeigt die letzte Transformation mit der Mono-spur

Das Ergebnis der letzen Iteration ist hier zu hören:

Audio V: der fünfte Klang

✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴

✅ 2.Ergebnis (OMPrisma)

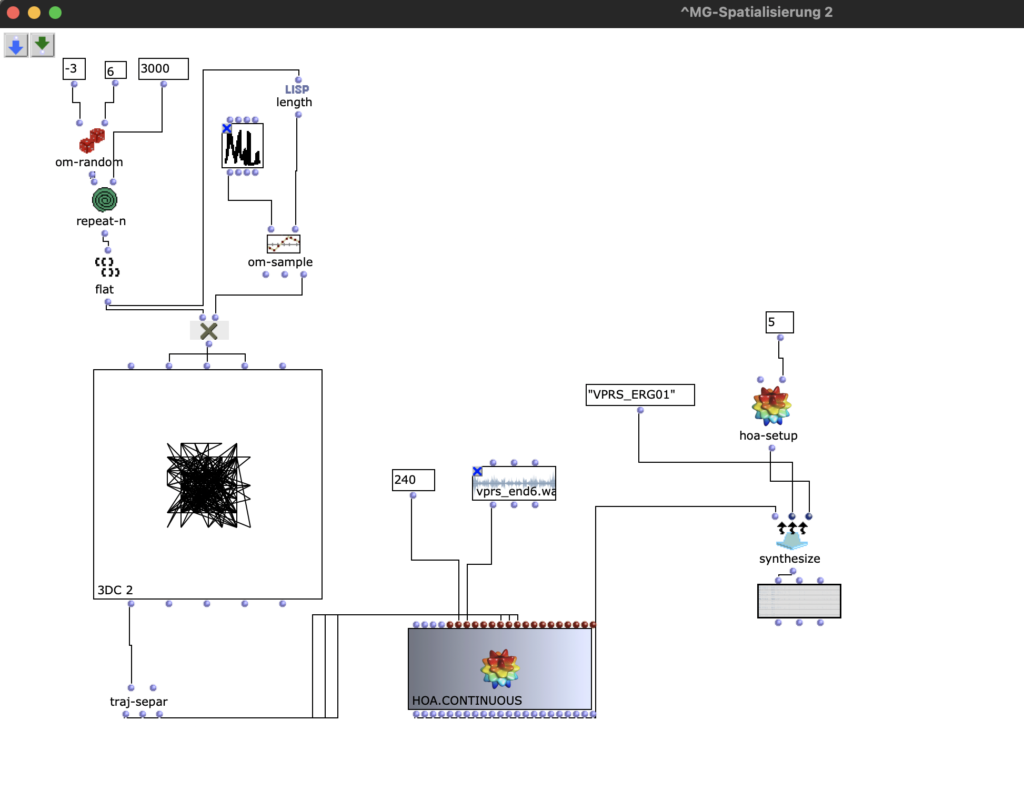

Dann habe ich die resultierenden Audio Dateien mit OMPrisma bearbeiten (s. Fig 7).

Hauptidee von Herrn Takasugi ist, dass Komponist (und Musiker) muss sehr persönlich Musik zu produzieren. Man muss „sich“ in der Komposition mitbringen.

Die Idee, dass Man „sich“ in der Komposition mitbringen muss, praktisch bedeutet aber auch, dass man irgendwelche zufällige Elemente mitbringt. Zufällige Elemente sind notwendig: als Menschen wir machen Fehler, wir können was übersehen, oder spontan entscheiden. Ich benutze OM-random um diese zufällige Elemente in der Komposition zu integrieren.

Fg. 7 zeigt OpenMusic Patch „OMPrisma“: Dieser Patch zeigt die Transformation mit HOA.Continuous

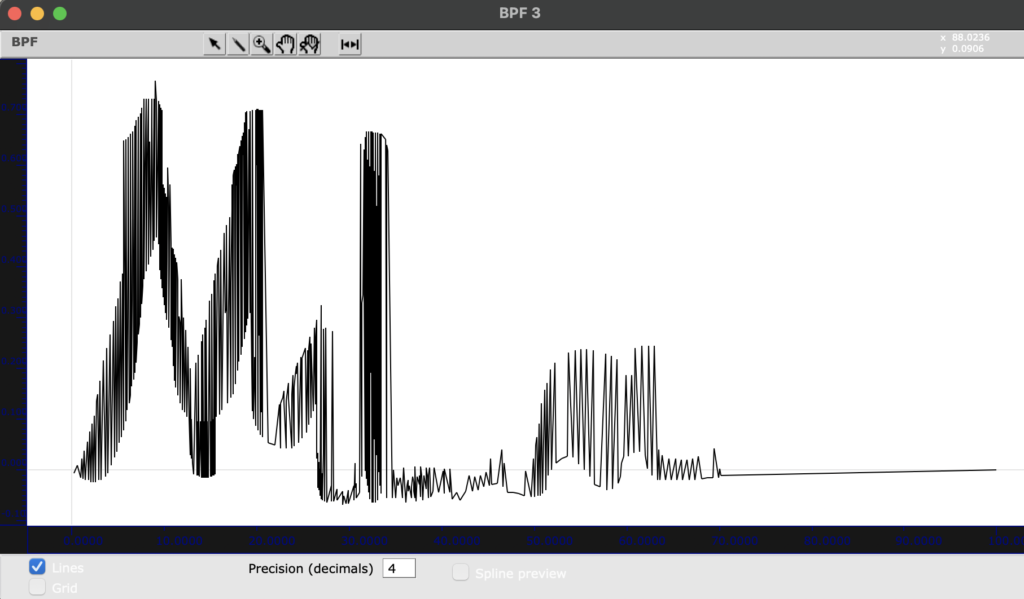

Als eine Methode um Komposition zu personifizieren benutze ich meine Name (Mila) als Muster für die Bewegung (s. Fig 8).

Fg. 8 zeigt OpenMusic Objekt „BPF“: Dieses Objekt zeigt mein Name als Muster für die Transformationen.

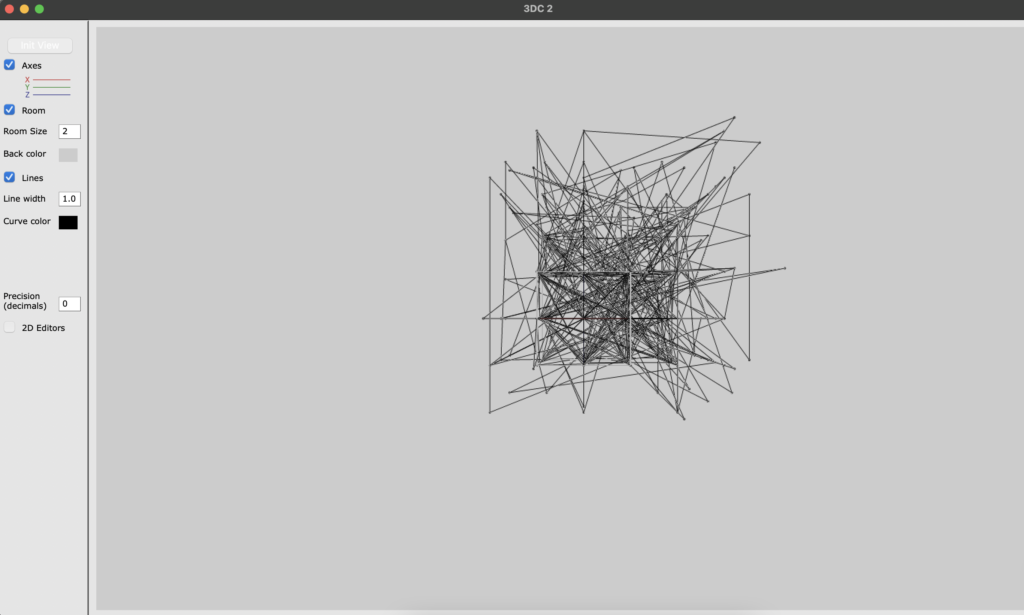

Dann benutze 3D OpenMusic Objekt. Mann kann auch 3D gut sehen (s. Fig. 9).

Fg. 9 zeigt OpenMusic Objekt „3DC“: Dieses Objekt zeigt die Transformationen.

Mit dem traj-separ Objekt kann man x-, y-, z- Koordinate nach HOA.Continuous schicken. Bei HOA.Continuous kann man auch die Länge der Komposition auszuwählen (im Sek). In meinem Fall steht 240, was 4 Minuten bedeutet.

Dann mit hoa-setup kann man auswählen, welche Klas von HOA man braucht. In meinem Fall ist HOA-setup 5, das bedeutet, dass ich High Order Ambisonic benutze.

Mann kann First Order Ambisonic und High Order Ambisonic unterscheiden. First Order Ambisonic ist eine Aufnahmemöglichkeit für 3D-Sound („First Order Ambisonic“ (FOA)), das aus vier Kanälen besteht und kann u.a. auch in verschiedene 2D-Formate exportiert werden (z. B. Stereo-, Surround-Sound).

Mit Ambisonic höherer Ordnung kann man Schallquellen noch genauer lokalisieren. Mann kann eine genauere Bestimmung des Winkels realisieren. Je höher die Ordnung, desto mehr Sphären kommen dazu.

„The increasing number of components gives us higher resolution in the domain of sound directivity. The amount of B-format components in High order Ambisonics (HOA) is connected with formula for 3D Ambisonics: (? + 1)2 or for 2D Ambisonics 2? + 1 where n is given Ambisonics order“. (C)

✅ Ergebnis OpenMusic Projekts mit OMPrisma kann man ? hier ? als Audio downloaded.

✅ Ergebnis OpenMusic Projekts mit OMPrisma kann man ? hier ? als Code downloaded.

✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴✴

✅ Reaper

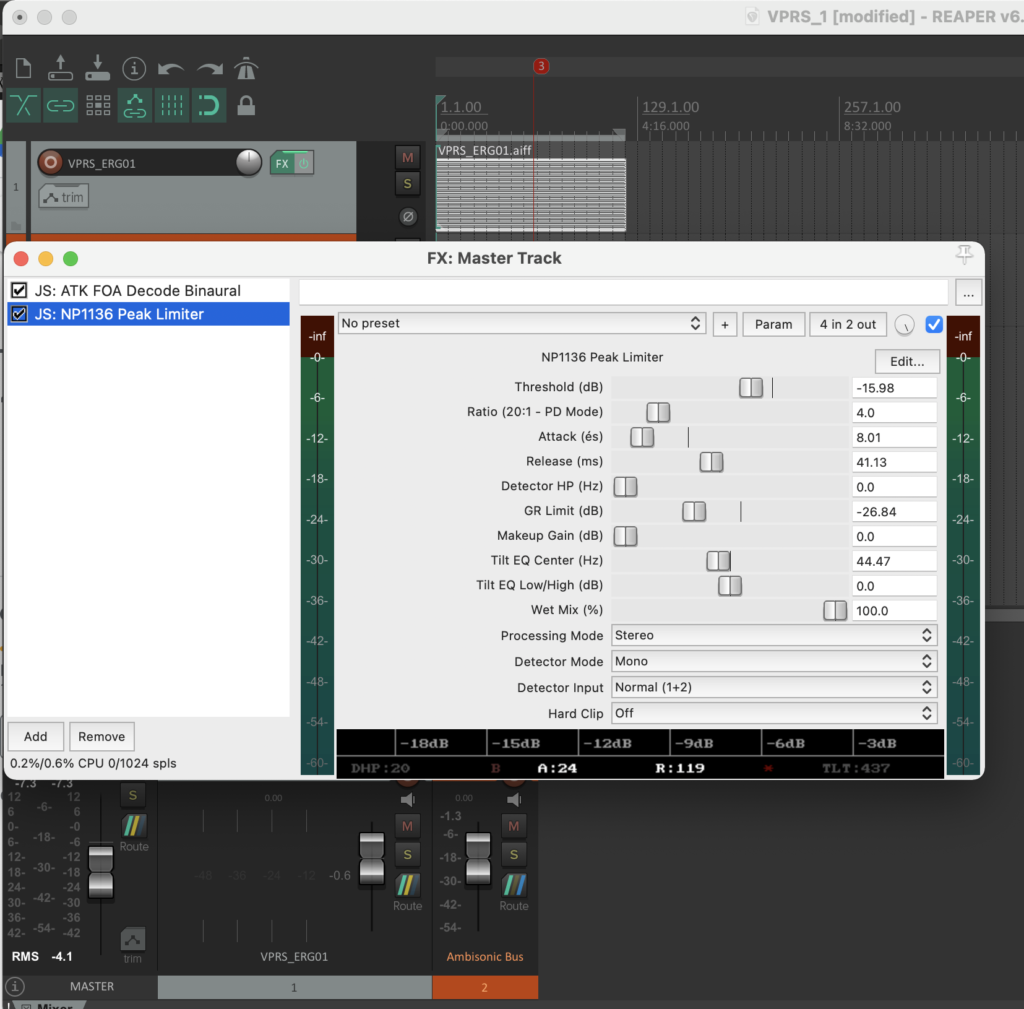

Dann habe ich die resultierenden Audio Dateien in ein Reaper Projekt importiert und die Ambisonics Audiospuren mit Plugins bearbeitet und neue Manipulationen gemacht.

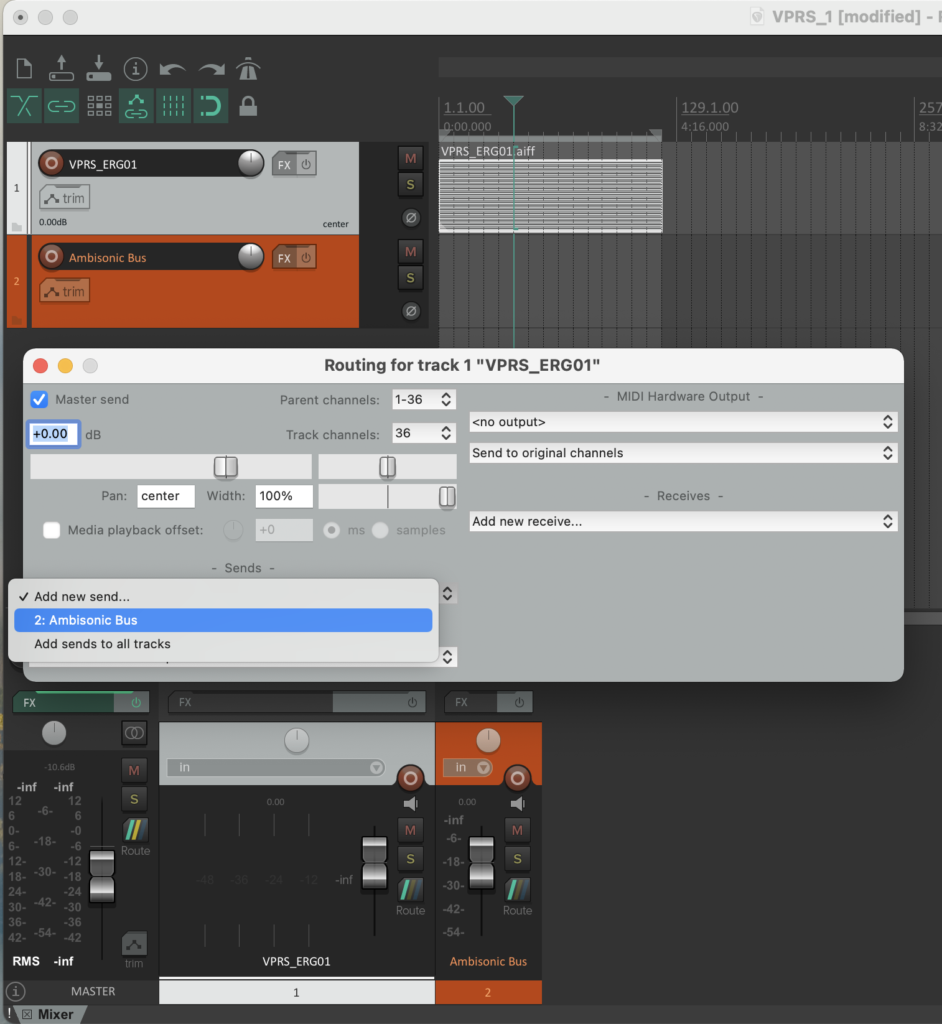

Nach dem das Audio material ist in Reaper hinzugefügt, muss man Routing machen. Hauptidee ist, dass 36 Kanäle werden beim ausgewählt und gesendet nach Ambisonic Buss (neuer Spur (s. Fig 10)).

Fg. 10 zeigt Reaper Projekt: Schritt Routing (36 Kanäle), sends nach Ambisonic Bus

✅ Mixing & Plugins

Ich habe die Kodierung des vorbereiteten Materials in das B-Format gemacht, automatisierte dynamische spaialisieung verwendet habe. Ich habe auch dynamische Korrektur (Limiter) gemacht.

Mit Plugins kann man den Sound nach Belieben verändert und verbessert. In der Audiotechnik sind Erweiterungen für DAWs, auch die, die veschidene Instrumente simulieren, oder Hall und Echo hinzufugen. Die habe ich Reaper verwendet:

✅IEM Plug-in Suite.

✅ambiX v0.2.10 – Ambisonic plug-in suite.

✅ATK_for_Reaper_Mac_1.0.b11.

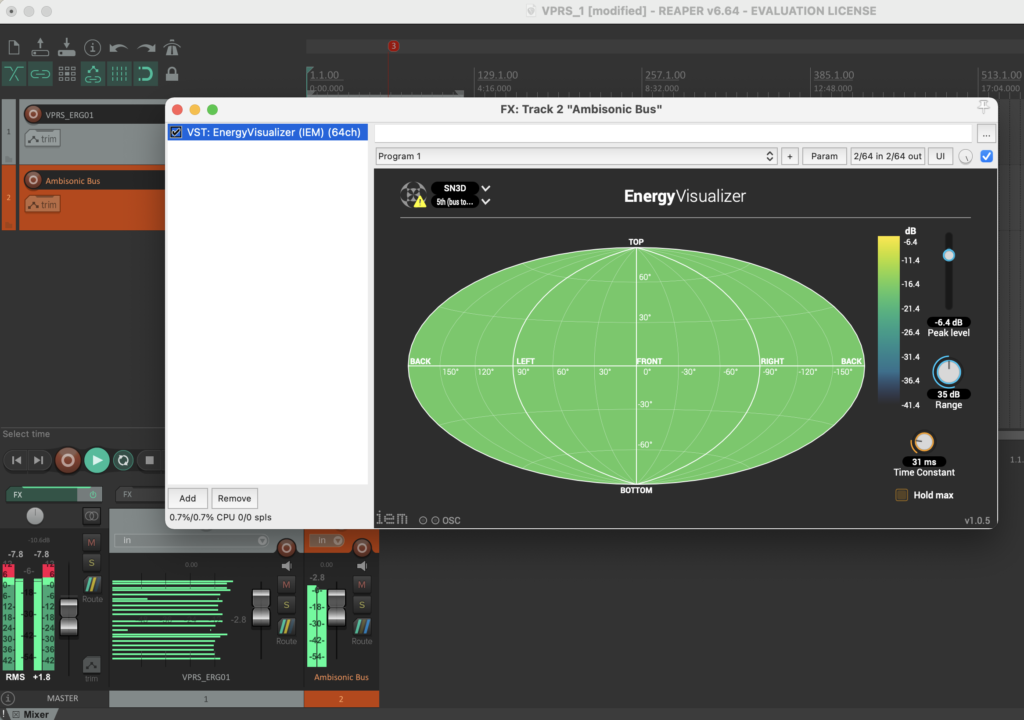

In dem Spur Ambisonic Bus habe ich (s. Fig 11):

✅VST: EnergyVisualizer (IEM) (64ch) hinzugefügt.

Fg. 11 zeigt Reaper Projekt: Ambisonic Bus VST Plugin (VST: EnergyVisualizer (IEM) (64ch)).

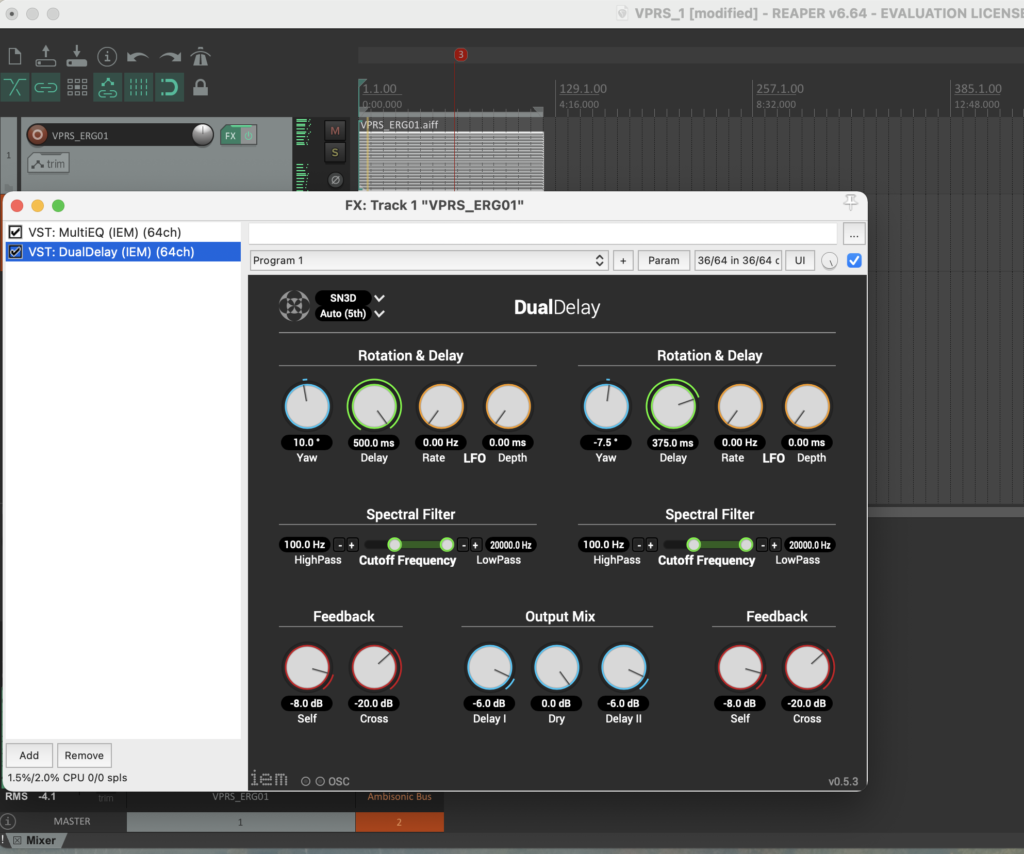

Dann habe ich mit den PlugIn EQ redaktiert (s. Fig 12). Ich habe:

✅VST: Multi EQ (IEM) (64ch) hinzugefügt.

Fg. 12 zeigt Reaper Projekt: Spur „VPRS-Projekt“ und VST Plugin (VST: Multi EQ (IEM) (64ch)).

Dann habe ich mit den PlugIn DualDelay delay hinzugefügt (s. Fig 13).

✅VST: DualDelay (IEM) (64ch).

Fg. 13 zeigt Reaper Projekt: Spur „VPRS-Projekt“ und VST Plugin (VST: DualDelay (IEM) (64ch)).

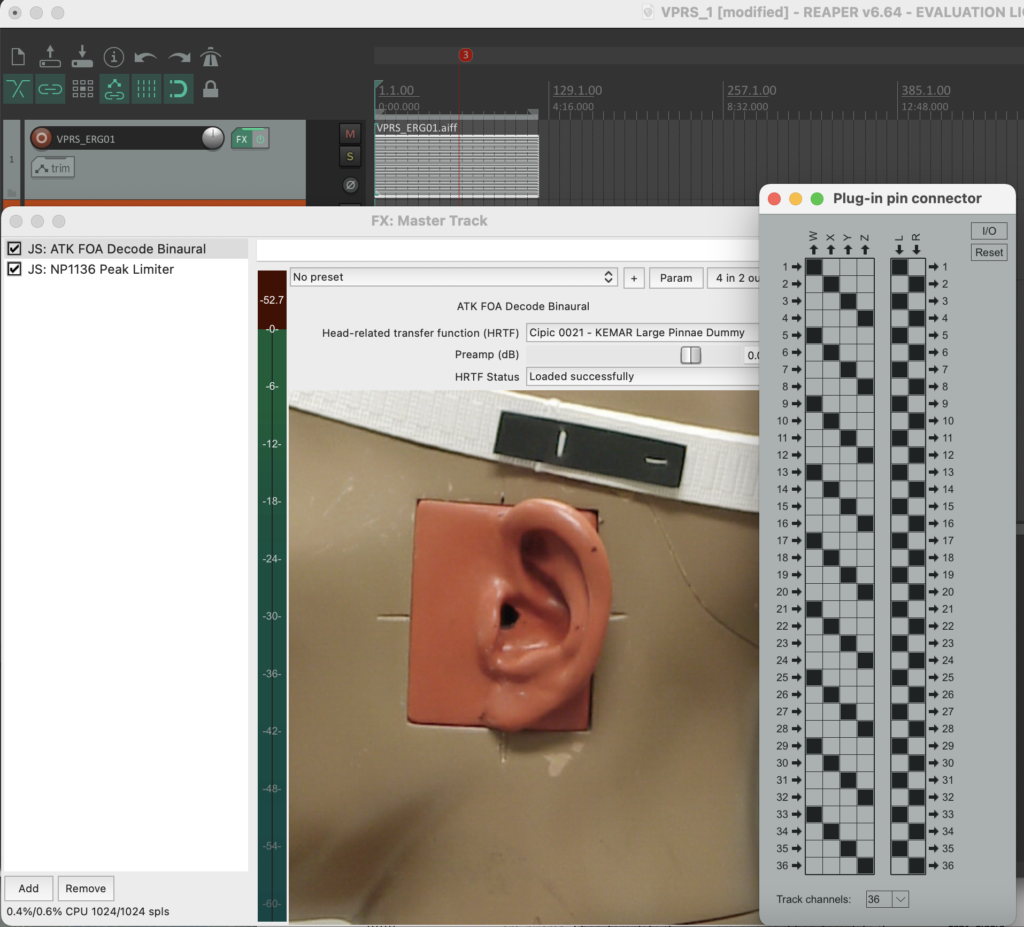

Dann habe ich zum Master Track JS: ATK FOA Decode Binaural hinzugefügt (s. Fig 14).

✅JS: ATK FOA Decode Binaural.

Fg. 14 zeigt Reaper Projekt: Spur Master Track mit JS: ATK FOA Decode Binaural .

Dann habe ich zum Master Track mit JS: NP1136 Pea Limiter (s. Fig 15).

✅JS: ATK FOA Decode Binaural.

Fg. 15 zeigt Reaper Projekt: Spur Master Track mit JS: NP1136 Peak Limiter

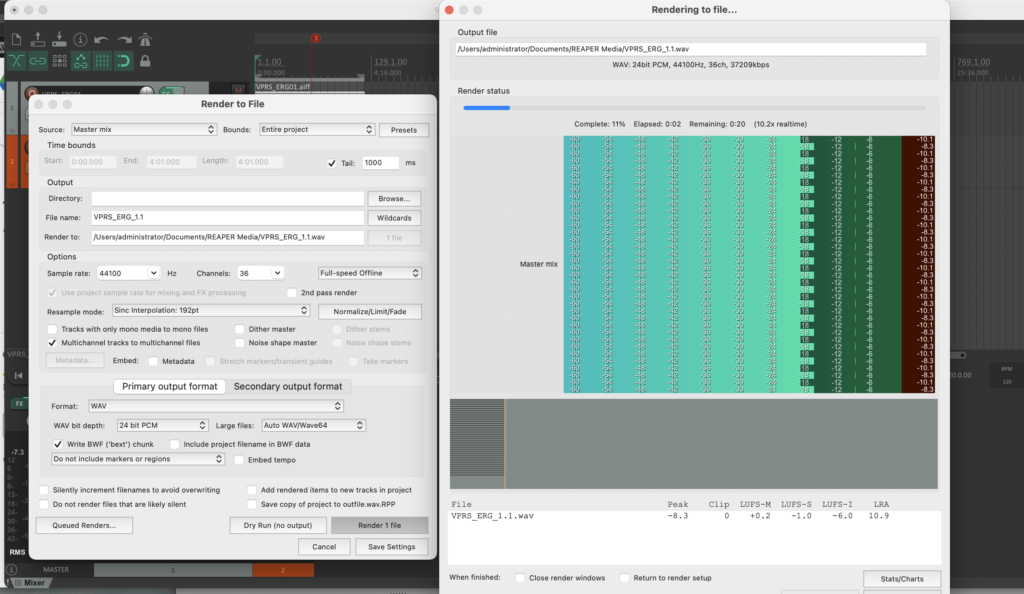

Dann habe ich Rendering gemacht (s. Fig 16).

✅Render to File

Fg. 16 zeigt Reaper Projekt: Render to File

✅ Ergebnis Reaper Projekts kann man ? hier ? (Audio, Reaper Project, OM Code) downloaded.